کیفیت داده (Data Quality)

کیفیت داده معیاری است برای وضعیت داده ها بر اساس عواملی مانند دقت، کامل بودن، سازگاری، قابلیت اطمینان و به روز بودن آنها. اندازهگیری سطوح کیفیت دادهها میتواند به سازمانها کمک کند تا خطاهای دادهای را که باید برطرف شوند شناسایی کرده و ارزیابی کنند که آیا دادهها در سیستمهای فناوری اطلاعات آنها برای خدمت به هدف مورد نظرشان مناسب هستند یا خیر.

تاکید بر کیفیت داده ها در سیستم های سازمانی افزایش یافته است زیرا پردازش داده ها به طور پیچیده تر با عملیات تجاری مرتبط شده است و سازمان ها به طور فزاینده ای از تجزیه و تحلیل داده ها برای کمک به تصمیم گیری های تجاری استفاده می کنند. مدیریت کیفیت داده جزء اصلی فرآیند کلی مدیریت داده است و تلاشهای بهبود کیفیت داده اغلب به برنامههای حاکمیت دادهها مرتبط است که هدف آن اطمینان از قالببندی و استفاده مداوم دادهها در سراسر سازمان است.

چرا کیفیت داده مهم است

داده های بد می تواند عواقب تجاری قابل توجهی برای شرکت ها داشته باشد. دادههای با کیفیت پایین اغلب بهعنوان منبع ناسازگاری عملیاتی، تحلیلهای نادرست و استراتژیهای کسبوکار بد تصور میشوند. نمونههایی از آسیبهای اقتصادی مشکلات کیفیت دادهها شامل هزینههای اضافی زمانی که محصولات به آدرسهای مشتری اشتباه ارسال میشوند، فرصتهای فروش از دست رفته به دلیل سوابق اشتباه یا ناقص مشتری، و جریمههای گزارشدهی نادرست انطباق مالی یا مقرراتی است.

شرکت مشاوره گارتنر در سال 2021 اعلام کرد که کیفیت بد داده ها به طور متوسط 12.9 میلیون دلار در سال برای سازمان ها هزینه دارد. رقم دیگری که هنوز هم اغلب ذکر می شود، محاسبه ای است که توسط IBM انجام شده است که نشان می دهد هزینه سالانه مسائل مربوط به کیفیت داده ها در ایالات متحده در سال 2016 به 3.1 تریلیون دلار رسیده است. و در مقاله ای که او برای بررسی مدیریت اسلون MIT در سال 2017 نوشت، مشاور کیفیت داده ها، توماس ردمن، تخمین زد.

تصحیح خطاهای داده ها و مقابله با مشکلات تجاری ناشی از داده های بد به طور متوسط 15 تا 25 درصد از درآمد سالانه شرکت ها را به همراه دارد.

علاوه بر این، عدم اعتماد به دادهها از سوی مدیران شرکتها و مدیران تجاری معمولاً در میان موانع اصلی استفاده از هوش تجاری (BI) و ابزارهای تحلیلی برای بهبود تصمیمگیری در سازمانها ذکر میشود. همه اینها یک استراتژی مدیریت Data Quality موثر را ضروری می کند.

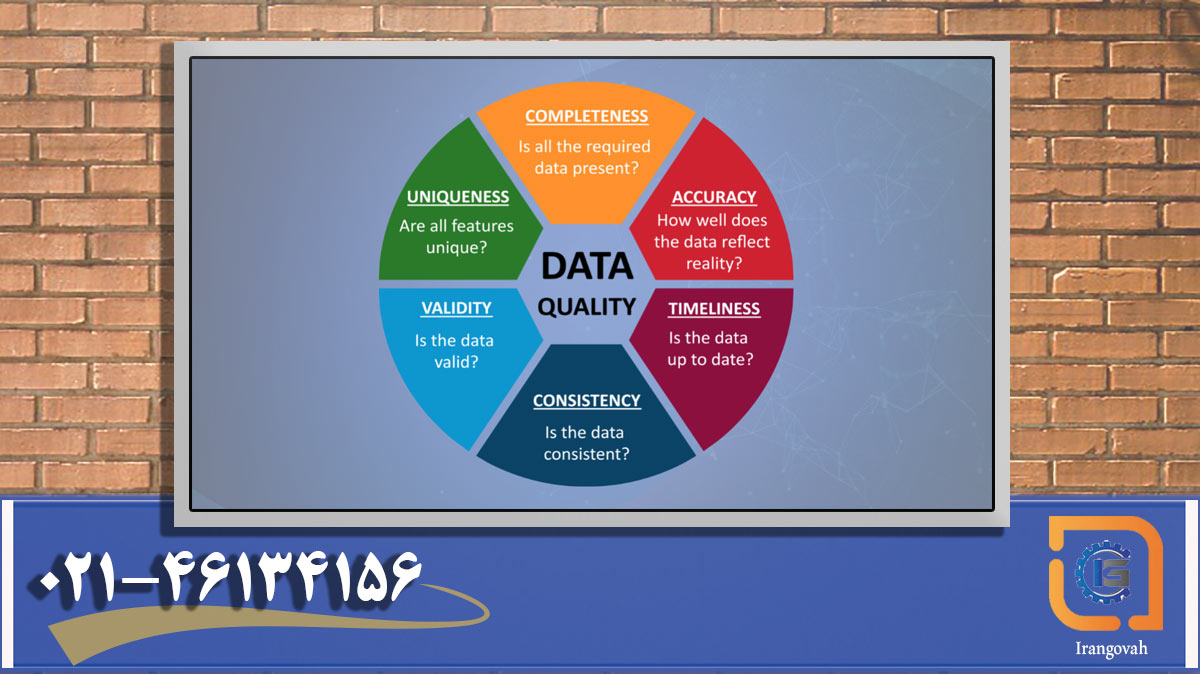

کیفیت داده خوب چیست؟

دقت داده ها یکی از ویژگی های کلیدی داده های با کیفیت است. برای جلوگیری از مشکلات پردازش تراکنش در سیستمهای عملیاتی و نتایج معیوب در برنامههای تحلیلی، دادههای مورد استفاده باید صحیح باشند. دادههای نادرست باید شناسایی، مستند و اصلاح شوند تا اطمینان حاصل شود که مدیران تجاری، تحلیلگران داده و سایر کاربران نهایی با اطلاعات خوب کار میکنند.

سایر جنبهها یا ابعادی که از عناصر مهم کیفیت دادههای خوب هستند عبارتند از:

- کامل بودن، با مجموعه دادههایی که شامل تمام عناصر دادهای هستند که باید.

- سازگاری، جایی که هیچ تضادی بین مقادیر داده های یکسان در سیستم ها یا مجموعه داده های مختلف وجود ندارد.

- منحصر به فرد بودن، نشان دهنده عدم وجود رکوردهای تکراری داده در پایگاه های داده و انبارهای داده است.

- به موقع بودن یا ارز، به این معنی که داده ها برای به روز نگه داشتن آن به روز شده اند و در صورت نیاز برای استفاده در دسترس هستند.

- اعتبار، تأیید اینکه داده ها حاوی مقادیری هستند که باید و به درستی ساختار یافته اند. و

- انطباق با فرمت های داده استاندارد ایجاد شده توسط یک سازمان.

رعایت همه این عوامل به تولید مجموعه داده هایی که قابل اعتماد و قابل اعتماد هستند کمک می کند. فهرست بلندبالایی از ابعاد اضافی کیفیت داده نیز می تواند اعمال شود – برخی از نمونه ها عبارتند از مناسب بودن، اعتبار، ارتباط، قابلیت اطمینان و قابلیت استفاده.

نحوه تعیین کیفیت داده ها

به عنوان اولین گام برای تعیین سطح کیفیت دادهها، سازمانها معمولاً داراییهای داده خود را فهرستبندی میکنند و مطالعات پایه را برای اندازهگیری دقت نسبی، منحصربهفرد بودن و اعتبار مجموعه دادهها انجام میدهند. سپس رتبهبندیهای پایه تعیینشده را میتوان با دادههای موجود در سیستمها به طور مداوم مقایسه کرد تا به شناسایی مسائل جدید کیفیت داده کمک کند.

گام متداول دیگر ایجاد مجموعه ای از قوانین کیفیت داده بر اساس الزامات تجاری برای داده های عملیاتی و تحلیلی است. چنین قوانینی سطوح کیفی مورد نیاز را در مجموعه دادهها مشخص میکند و جزئیاتی را که عناصر دادههای مختلف باید شامل شوند را مشخص میکند تا بتوان آنها را از نظر دقت، سازگاری و سایر ویژگیهای کیفیت داده بررسی کرد.

پس از وضع قوانین، یک تیم مدیریت داده معمولاً ارزیابی کیفیت داده ها را برای اندازه گیری کیفیت مجموعه داده ها و مستندسازی خطاهای داده و سایر مشکلات انجام می دهد – رویه ای که می تواند در فواصل زمانی منظم تکرار شود تا بالاترین سطح Data Quality را حفظ کند.

روش شناسی های مختلفی برای چنین ارزیابی هایی ایجاد شده است. به عنوان مثال، مدیران داده در شرکت تابعه خدمات بهداشتی درمانی اپتوم گروه UnitedHealth، چارچوب ارزیابی Data Quality (DQAF) را در سال 2009 ایجاد کردند تا روشی را برای ارزیابی کیفیت داده های آن رسمی کنند. DQAF دستورالعمل هایی را برای اندازه گیری کیفیت داده ها بر اساس چهار بعد ارائه می دهد: کامل بودن، به موقع بودن، اعتبار و سازگاری. Optum جزئیات مربوط به چارچوب را به عنوان یک مدل احتمالی برای سایر سازمان ها منتشر کرده است.

صندوق بینالمللی پول (IMF) که بر سیستم پولی جهانی نظارت میکند و به کشورهای دارای مشکل اقتصادی وام میدهد، یک روش ارزیابی با همان نام Optum را نیز مشخص کرده است. چارچوب آن بر دقت، قابلیت اطمینان، سازگاری و سایر ویژگیهای کیفیت داده در دادههای آماری که کشورهای عضو باید به صندوق بینالمللی پول ارسال کنند، تمرکز دارد. علاوه بر این، دفتر هماهنگ کننده ملی فناوری اطلاعات بهداشتی دولت ایالات متحده چارچوب کیفی دادهها را برای دادههای جمعیت شناختی بیمار جمعآوریشده توسط سازمانهای مراقبتهای بهداشتی به تفصیل ارائه کرده است.

ابزارها و تکنیک های مدیریت کیفیت داده ها

پروژه های کیفیت داده معمولاً چندین مرحله دیگر را نیز شامل می شوند. به عنوان مثال، چرخه مدیریت Data Quality که توسط مشاور مدیریت داده دیوید لوشین مشخص شده است، با شناسایی و اندازه گیری تأثیر داده های بد بر عملیات تجاری شروع می شود. در مرحله بعد، قوانین کیفیت داده تعریف میشوند، اهداف عملکرد برای بهبود معیارهای کیفیت دادههای مرتبط تنظیم میشوند و فرآیندهای بهبود کیفیت دادههای خاص طراحی و اجرا میشوند.

این فرآیندها شامل پاکسازی دادهها، یا پاکسازی دادهها، برای رفع خطاهای داده، بهعلاوه کار برای بهبود مجموعه دادهها با افزودن مقادیر گمشده، اطلاعات بهروزتر یا سوابق اضافی است. سپس نتایج بر اساس اهداف عملکردی پایش و اندازهگیری میشوند، و هرگونه نقص باقیمانده در کیفیت داده نقطه شروعی برای دور بعدی بهبودهای برنامهریزیشده است. چنین چرخه ای برای اطمینان از ادامه تلاش ها برای بهبود کیفیت کلی داده ها پس از تکمیل پروژه های فردی در نظر گرفته شده است.

برای کمک به سادهسازی چنین تلاشهایی، ابزارهای نرمافزاری با کیفیت دادهها میتوانند سوابق را مطابقت دهند، موارد تکراری را حذف کنند، دادههای جدید را تأیید کنند، سیاستهای اصلاح را ایجاد کنند و دادههای شخصی را در مجموعههای داده شناسایی کنند. آنها همچنین پروفایل داده را برای جمع آوری اطلاعات در مورد مجموعه داده ها و شناسایی مقادیر پرت احتمالی انجام می دهند. توابع کیفیت دادههای افزوده مجموعهای از قابلیتهای نوظهور هستند که فروشندگان نرمافزار در ابزارهای خود برای خودکارسازی وظایف و رویهها، عمدتاً از طریق استفاده از هوش مصنوعی (AI) و یادگیری ماشینی، ایجاد میکنند.

کنسولهای مدیریتی برای طرحهای کیفی دادهها از ایجاد قوانین مدیریت داده، کشف روابط دادهها و تبدیل خودکار دادهها پشتیبانی میکنند که ممکن است بخشی از تلاشهای نگهداری Data Quality باشد. ابزارهای فعالسازی همکاری و گردش کار نیز رایجتر شدهاند و دیدگاههای مشترکی از مخازن دادههای شرکتی را برای مدیران کیفیت داده و مباشران داده ارائه میدهند که وظیفه نظارت بر مجموعههای داده خاص را بر عهده دارند.

ابزارهای کیفیت داده و فرآیندهای بهبود اغلب در برنامه های حاکمیت داده گنجانده می شوند، که معمولاً از معیارهای کیفیت داده برای کمک به نشان دادن ارزش تجاری خود برای شرکت ها استفاده می کنند. آنها همچنین اجزای کلیدی ابتکارات مدیریت داده اصلی (MDM) هستند که ثبت مرکزی دادههای اصلی را روی مشتریان، محصولات و زنجیرههای تامین، در میان سایر حوزههای داده ایجاد میکنند.

مزایای کیفیت داده خوب

از نقطه نظر مالی، حفظ سطح کیفی دادههای بالا سازمانها را قادر میسازد تا هزینه شناسایی و تعمیر دادههای بد در سیستمهای خود را کاهش دهند. شرکتها همچنین میتوانند از خطاهای عملیاتی و خرابی فرآیندهای تجاری که میتواند هزینههای عملیاتی را افزایش داده و درآمد را کاهش دهد، اجتناب کنند.

علاوه بر این، کیفیت خوب داده ها، دقت برنامه های تحلیلی را افزایش می دهد، که می تواند منجر به تصمیم گیری بهتر تجاری شود که فروش را افزایش می دهد، فرآیندهای داخلی را بهبود می بخشد و به سازمان ها برتری رقابتی نسبت به رقبا می دهد. دادههای با کیفیت بالا میتوانند به گسترش استفاده از داشبوردهای BI و ابزارهای تجزیه و تحلیل نیز کمک کنند – اگر دادههای تجزیه و تحلیل قابل اعتماد تلقی شوند، کاربران تجاری بهاحتمالزیاد به جای تصمیمگیری بر اساس احساسات واقعی یا صفحات گسترده خودشان، به آن تکیه میکنند.

مدیریت مؤثر کیفیت دادهها همچنین تیمهای مدیریت داده را آزاد میکند تا روی کارهای سازندهتر از پاکسازی مجموعههای داده تمرکز کنند. به عنوان مثال، آنها می توانند زمان بیشتری را برای کمک به کاربران تجاری و تحلیلگران داده صرف کنند تا از داده های موجود در سیستم ها استفاده کنند و بهترین شیوه های کیفیت داده را در عملیات تجاری ارتقا دهند تا خطاهای داده را به حداقل برسانند.

چالش های نوظهور کیفیت داده ها

برای سالها، بار تلاشهای کیفیت دادهها بر روی دادههای ساختاریافته ذخیرهشده در پایگاههای داده رابطهای متمرکز بود، زیرا آنها فناوری غالب برای مدیریت دادهها بودند. اما ماهیت مشکلات Data Quality با برجستهتر شدن سیستمهای کلان داده و محاسبات ابری گسترش یافت. مدیران دادهها به طور فزایندهای باید روی کیفیت دادههای غیرساختیافته و نیمهساختارمند مانند متن، رکوردهای جریان کلیک اینترنتی، دادههای حسگر و شبکه، گزارشهای سیستم و برنامهها تمرکز کنند. علاوه بر این، کیفیت داده ها در حال حاضر اغلب نیاز به مدیریت در ترکیبی از سیستم های داخلی و ابری دارد.

استفاده روزافزون از ابزارهای هوش مصنوعی و برنامه های کاربردی یادگیری ماشین در سازمان ها، فرآیند کیفیت داده ها را پیچیده تر می کند، همانطور که استفاده از پلتفرم های جریان داده در زمان واقعی که حجم زیادی از داده ها را به طور مداوم به سیستم های شرکت منتقل می کند، پیچیده تر می شود. خطوط لوله داده پیچیده ایجاد شده برای پشتیبانی از علم داده و کار تجزیه و تحلیل پیشرفته نیز به چالشها میافزاید.

تقاضاهای کیفیت داده نیز به دلیل اجرای قوانین جدید حفظ حریم خصوصی و حفاظت از داده ها، به ویژه مقررات عمومی حفاظت از داده های اتحادیه اروپا (GDPR) و قانون حفظ حریم خصوصی مصرف کنندگان کالیفرنیا (CCPA) در حال گسترش است. هر دو معیار به افراد حق دسترسی به دادههای شخصی را میدهند که شرکتها در مورد آنها جمعآوری میکنند، به این معنی که سازمانها باید بتوانند تمام سوابق یک فرد را در سیستمهای خود بدون از دست دادن به دلیل دادههای نادرست یا متناقض پیدا کنند.

رفع مشکلات کیفیت داده ها

مدیران کیفیت داده ها، تحلیلگران و مهندسان در درجه اول مسئول رفع خطاهای داده ها و سایر مشکلات کیفیت داده در سازمان ها هستند. آنها به طور جمعی وظیفه یافتن و پاکسازی داده های بد در پایگاه های داده و سایر مخازن داده ها را دارند، اغلب با کمک و پشتیبانی سایر متخصصان مدیریت داده، به ویژه مباشران داده و مدیران برنامه های مدیریت داده.

با این حال، مشارکت دادن کاربران تجاری، دانشمندان داده و سایر تحلیلگران در فرآیند کیفیت داده ها برای کمک به کاهش تعداد مشکلات Data Quality ایجاد شده در سیستم ها، یک روش معمول است. مشارکت تجاری را می توان تا حدی از طریق برنامه های حاکمیت داده و تعامل با مباشران داده، که اغلب از واحدهای تجاری می آیند، به دست آورد. علاوه بر این، بسیاری از شرکتها برنامههای آموزشی را در مورد بهترین شیوههای کیفیت داده برای کاربران نهایی اجرا میکنند. یک شعار رایج در بین مدیران داده این است که همه افراد در یک سازمان مسئول کیفیت داده هستند.

کیفیت داده در مقابل یکپارچگی داده ها

کیفیت داده ها و یکپارچگی داده ها گاهی اوقات به جای هم نامیده می شوند. به طور متناوب، برخی افراد یکپارچگی داده ها را به عنوان جنبه ای از دقت داده یا بعد جداگانه ای از کیفیت داده ها در نظر می گیرند. با این حال، به طور کلی تر، یکپارچگی داده ها به عنوان یک مفهوم گسترده تری دیده می شود که Data Quality، حاکمیت داده و مکانیسم های حفاظت از داده را برای رسیدگی به دقت، ثبات و امنیت داده به عنوان یک کل ترکیب می کند.

در آن دیدگاه گسترده تر، یکپارچگی داده ها بر یکپارچگی از دیدگاه منطقی و فیزیکی تمرکز دارد. یکپارچگی منطقی شامل معیارهای کیفیت داده ها و ویژگی های پایگاه داده مانند یکپارچگی ارجاعی است که تضمین می کند که عناصر داده مرتبط در جداول پایگاه داده های مختلف معتبر هستند. یکپارچگی فیزیکی شامل کنترلهای دسترسی و سایر اقدامات امنیتی است که برای جلوگیری از تغییر یا خراب شدن دادهها توسط کاربران غیرمجاز، و همچنین محافظتهای پشتیبان و بازیابی فاجعه طراحی شدهاند.